안녕하세요!

오늘은 GCP사용법의 대장정을 찍을 마지막으로 cuDNN 사용법에 대해 간략하게 작성한 뒤 GCP 사용법에 대해 마무리할까 합니다!

※참고로 저도 GCP 사용이 처음이라 미숙하고 다 알지는 못합니다!

따라서 아래 포스팅 내용 중 틀린 부분이 있다면 댓글로 알려주시면 감사하겠습니다!!

먼저 cuDNN을 설치하기 전에 cuDNN이란 뭘까요?

0. cuDNN이란?

cuDNN이란 cuda Deep Neural Netework Library의 약자로 딥러닝 및 인공 신경망(ANN) 프레임워크를 가속화하기 위한 라이브러리이다.

간단히 말해서 GPU의 궁극적인 목표는 딥러닝 계산을 가속화하는 것이고, cuDNN은 이런 가속을 더욱 최적화해주는 라이브러리입니다. 특히 합성곱 신경망(CNN) 연산을 빠르게 수행할 수 있도록 도와줍니다.

하지만 cuDNN의 설치가 필수는 아닙니다!

PyTorch나 TensorFlow를 GPU에서 사용하려면 기본적으로 CUDA가 필요하며, cuDNN을 추가로 설치하면 성능이 더욱 향상되지만, PyTorch나 TensorFlow를 설치할 때 CUDA와 cuDNN이 포함된 버전을 선택하면 별도로 설치하지 않아도 됩니다.

만약, 내가 다양한 딥러닝 프레임워크(Pytorch, TensorFlow, JAX 등)를 공용으로 사용해야 한다면, cuDNN을 설치한 후 다양한 프레임워크를 깔 때 유리합니다.

그럼 한번 cuDNN을 설치방법에 대해 알아보도록 하겠습니다!

1. cuDNN 설치

1-1. cuDNN 설치

우선 해당 링크로 들어가서 자신의 환경에 맞게 필터를 걸어 제 환경에 적합한 설치코드를 터미널에 입력합니다.

저는 OS가 debian이므로 Distribution을 Debian으로 선택합니다.

Installer Type에서 좀 헷갈렸는데요 , Installer Type에서 deb(local)과 deb(network)이 차이는 인터넷 연결의 유무라고 합니다. deb(network)의 경우 인터넷 연결이 가능할 때, 설치하는 방법으로 설치 크기가 좀 더 작다고 하니 저는 deb(network)로 설치를 진행하도록 하겠습니다.

이렇게 필터를 걸고 나면 아래와 같은 Installation Instructions가 나오게 됩니다.

$ wget https://developer.download.nvidia.com/compute/cuda/repos/debian12/x86_64/cuda-keyring_1.1-1_all.deb

$ sudo dpkg -i cuda-keyring_1.1-1_all.deb

$ sudo apt-get update

$ sudo apt-get -y install cudnn-cuda-11저는 CUDA 11.4 버전을 사용하기 때문에 위와 같은 코드를 입력하지만, 자신의 CUDA 버전을 확인한 뒤 그에 맞는 알맞는 버전을 작성해 입력하시기 바랍니다.

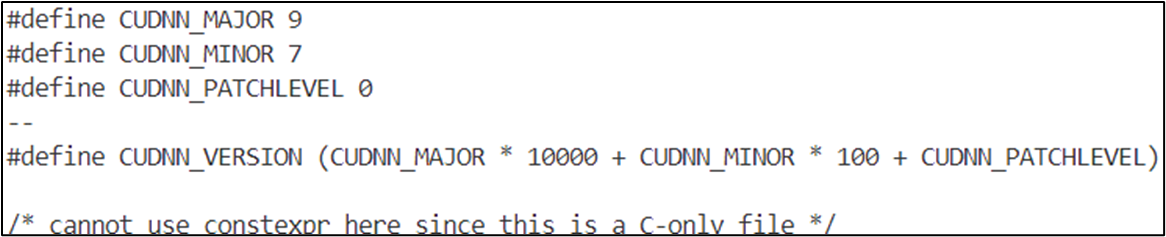

1-2. cuDNN 설치 확인

이제 cuDNN을 모두 설치하셨다면 아래와 같은 명령어를 입력합니다.

cat /usr/include/cudnn_version.h | grep CUDNN_MAJOR -A 2

위와 같은 결과가 나왔다면 cuDNN이 제대로 설치된 것입니다!

2. Pytorch 설치

이제 cuDNN을 설치했으니 저희의 궁극의 목표인 torch를 깔아보도록 하겠습니다!

꼭 torch만 깔 필요 없이 각자 프로젝트에 맞게 torch나 tensorflow를 깔면 되는데, 사실 여기서 torch와 tensorflow를 같이 깔면 어떤 버전에서는 충돌이 날 가능성이 있다고 합니다. (매우 권장하지 않는 방법이라고 해요!)

사실 그래서 miniconda를 이용해 가상환경을 만든 뒤 프로젝트에 맞게 torch나 tensorflow를 설치하고 가상환경별로 관리하는게 가장 best 방법입니다!

하지만 오늘은 miniconda까지는 다루지 않고 torch를 설치하는 법 까지만 알아보도록 하겠습니다!

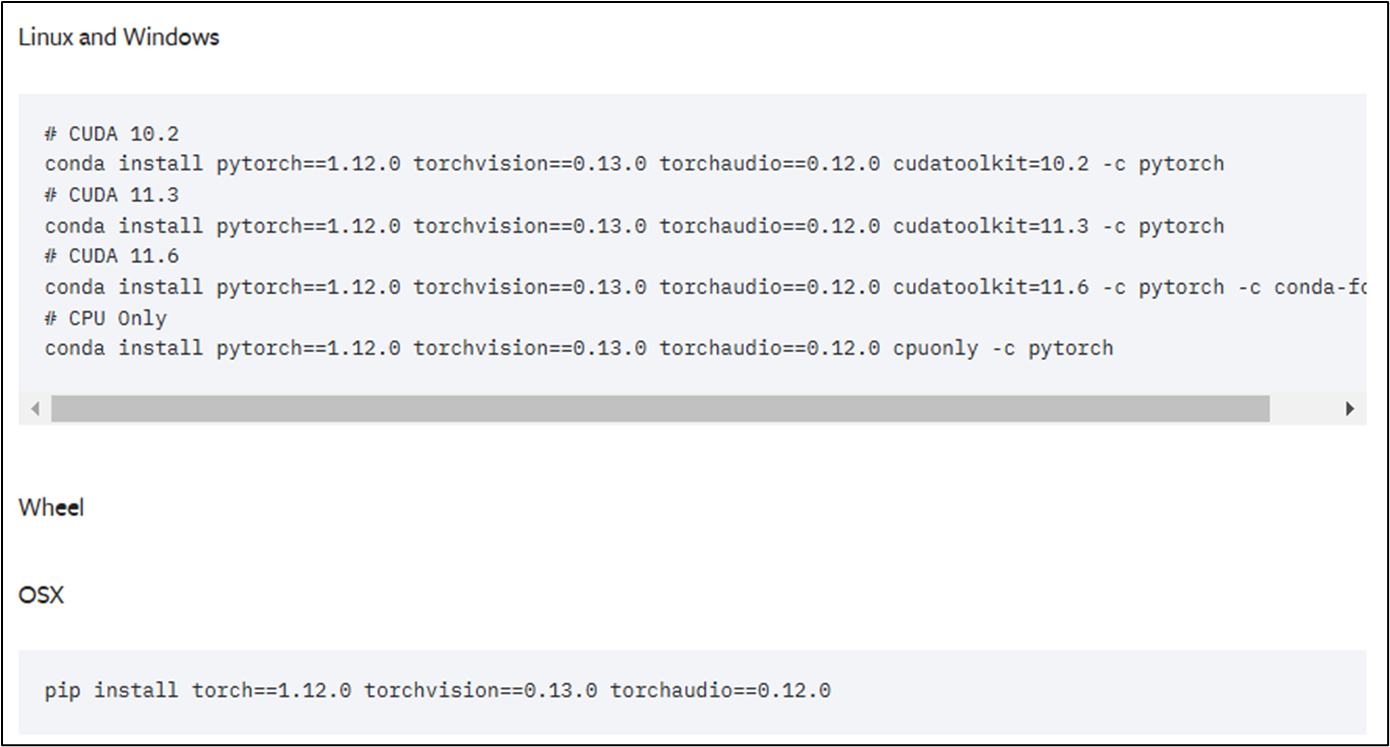

2-1. Pytorch 설치 방법

해당 링크로 들어가셔서 자신의 cuda 버전에 맞는 pytorch를 명령어를 입력해줍니다.

저는 CUDA가 11.4이므로 그보다 한단계 낮은 11.3을 설치하도록 하겠습니다.

여기서 자신의 CUDA보다 낮은 버전의 torch만 설치해야하나?라고 한다면 사실 그것까진 저도 잘 모르겠습니다. 아시는 분 댓글좀..!

일단은 혹시 몰라 낮은 버전으로 설치를 했는데 torch버전이 1.12.1로 너무 낮긴하네요ㅠ 자신이 돌릴 모델의 버전을 확인하고 그에 맞는 torch를 확인할 필요는 있어보입니다! 그리고 일단 깔아보는것도 하나의 방법일 듯 하네요!

2-2. Pytorch 설치 확인

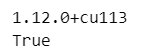

이렇게 Pytorch까지 깔았으면 이제 터미널이 아닌 파이썬에 아래와 같은 명령어를 입력해 Pytorch가 설치된 것을 확인해 봅시다!

import torch

print(torch.__version__)

print(torch.cuda.is_available())

저는 위의 CUDA 11.3 버전의 pytorch=1.12.0의 버전을 설치해서 1.12+cu113의 버전으로 Pytorch가 깔려있네요!

저렇게 'torch.cuda.is_available()'의 명령어를 입력하고 True가 나온다면 Pytorch가 잘 깔린 것입니다!

이렇게 pytorch까지 다 설치해보았습니다! 이제는 설치한 torch를 이용해 마음껏 딥러닝을 뺑뺑 돌리시기 바랍니다!!

지금까지 GCP에서 GPU 활용하는 법에 대해 봐주셔서 감사합니다!!

질문이나 잘못 작성된 부분이 있다면 댓글로 둥글게 알려주세요!